FLAIR

Artificial Intelligence challenges organised around geo-data and deep learning

Project maintained by IGNF

Bienvenue sur la page des datasets FLAIR de l'IGN!

|

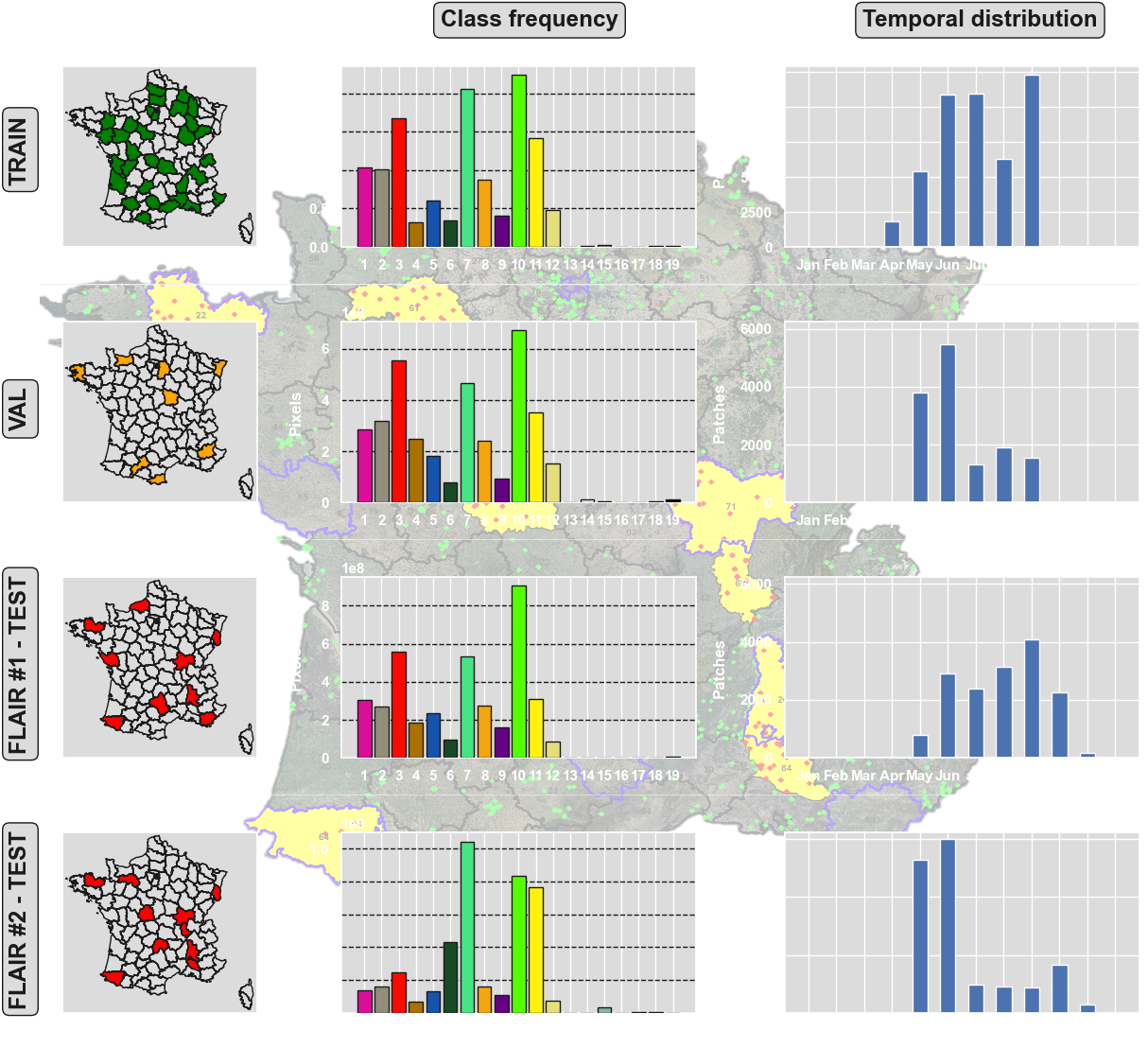

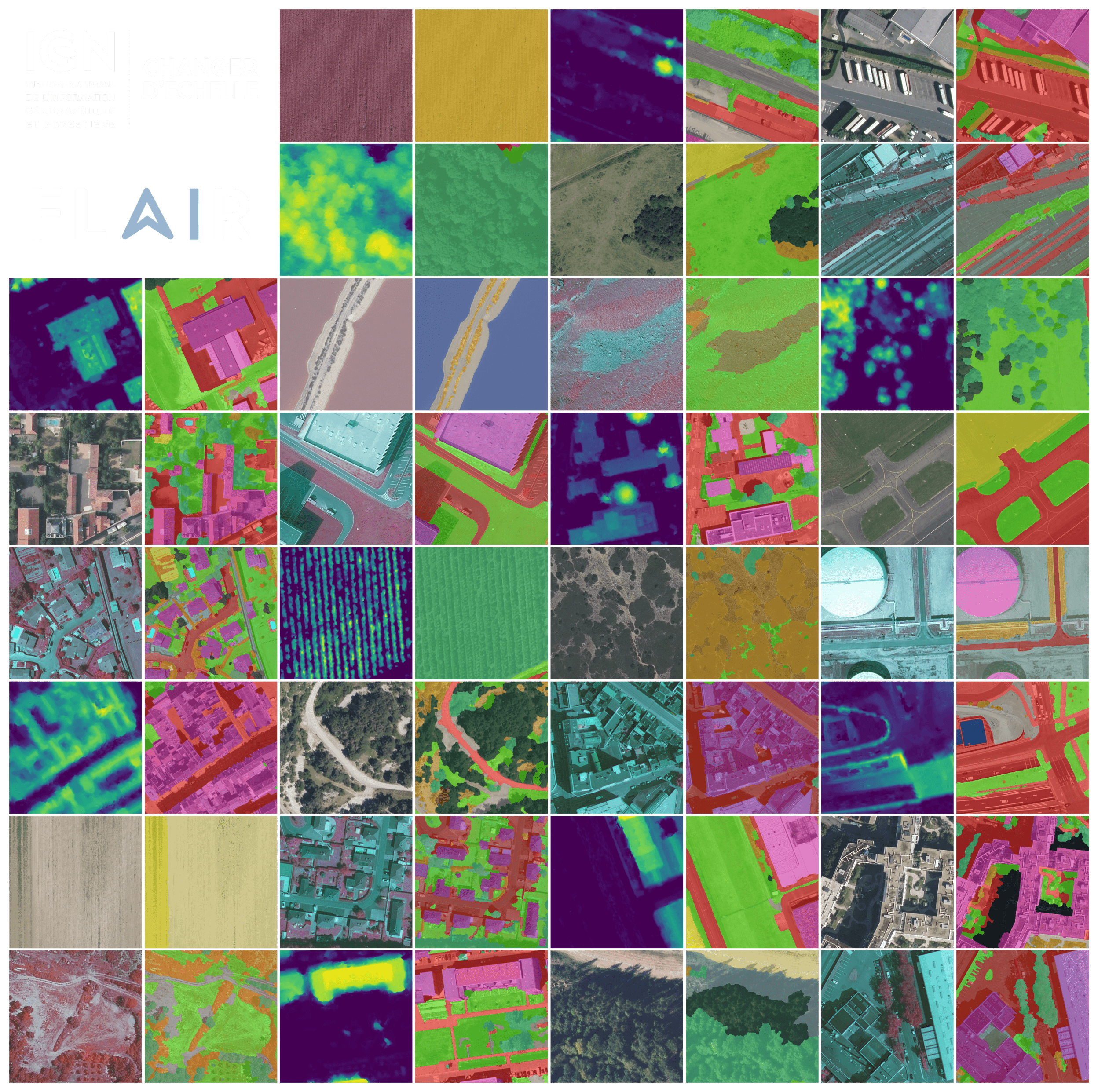

L'Institut national de l'information géographique et forestière (IGN) présente ses défis en matière d'IA et ses jeux de données de référence FLAIR (pour French Land cover from Aerospace ImageRy). Les jeux de données FLAIR mettent à disposition des données d'observation de la Terre provenant de différents capteurs aérospatiaux. Ces jeux de données couvrent de larges échelles et reflètent des cas réels et complexes de cartographie de l'occupation du sol. |

|||

|---|---|---|---|

|

|

|||

|

Les jeux de données FLAIR sont sous la licence Licence Ouverte 2.0 d'Etalab.

|

|||