FLAIR

Artificial Intelligence challenges organised around geo-data and deep learning

Project maintained by IGNF

FLAIR #2 : Information texturale et temporelle à partir d'imagerie optique multimodal pour la segmentation sémantique 🌍🌱🏠🌳➡️🛩️🛰️

Challenge organisé par l'IGN avec le soutient du CNES et de Connect by CNES dans le cadre d'un projet Copernicus / FPCUP.

FLAIR #2 datapaper 📑 : https://arxiv.org/pdf/2305.14467.pdf

FLAIR #2 NeurIPS datapaper 📑 : https://proceedings.neurips.cc/paper_files/paper/2023/file/353ca88f722cdd0c481b999428ae113a-Paper-Datasets_and_Benchmarks.pdf

FLAIR #2 NeurIPS poster 📑 : https://neurips.cc/media/PosterPDFs/NeurIPS%202023/73621.png?t=1699528363.252194

FLAIR #2 dépôt GitHub 📁 : https://github.com/IGNF/FLAIR-2

FLAIR #2 page du défi 💻 : https://codalab.lisn.upsaclay.fr/competitions/13447 [fermé]

Modèles pré-entraînés : pour l'instant sur demande !

▶️ Contexte du challenge (cliquer pour agrandir)

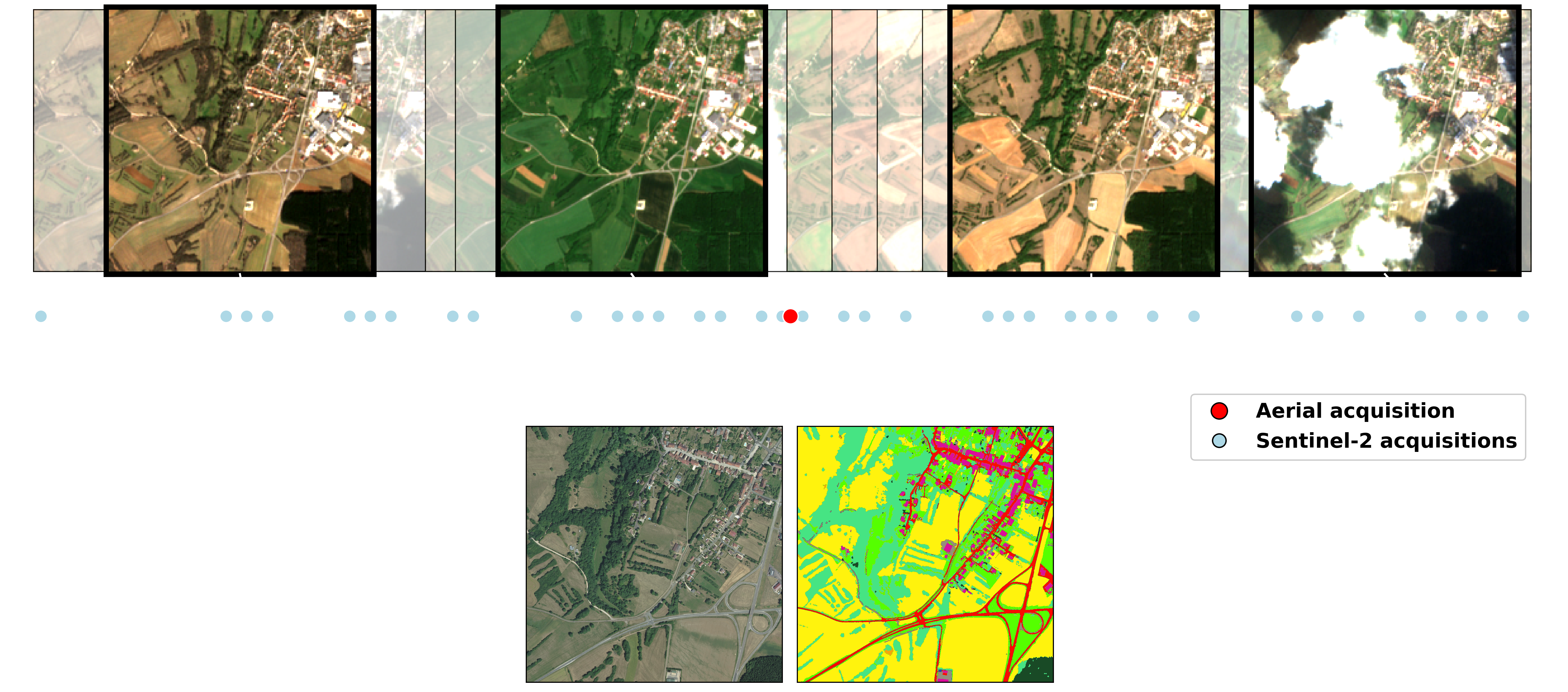

Avec ce nouveau défi, les participants auront pour tâche de développer des solutions innovantes qui peuvent exploiter efficacement les informations texturales des images aériennes prises à une seule date, ainsi que les informations temporelles/spectrales provenant des séries temporelles des satellites Sentinel-2, afin d'améliorer la segmentation sémantique, l'adaptation de domaine et l'apprentissage par transfert. Vos solutions devraient relever les défis liés à la conciliation des différentes périodes d'acquisition, des résolutions spatiales différentes, de l'adaptation aux conditions d'acquisitions variables et de la gestion de l'hétérogénéité des classes sémantiques.

▶️ Description du dataset (cliquer pour agrandir)

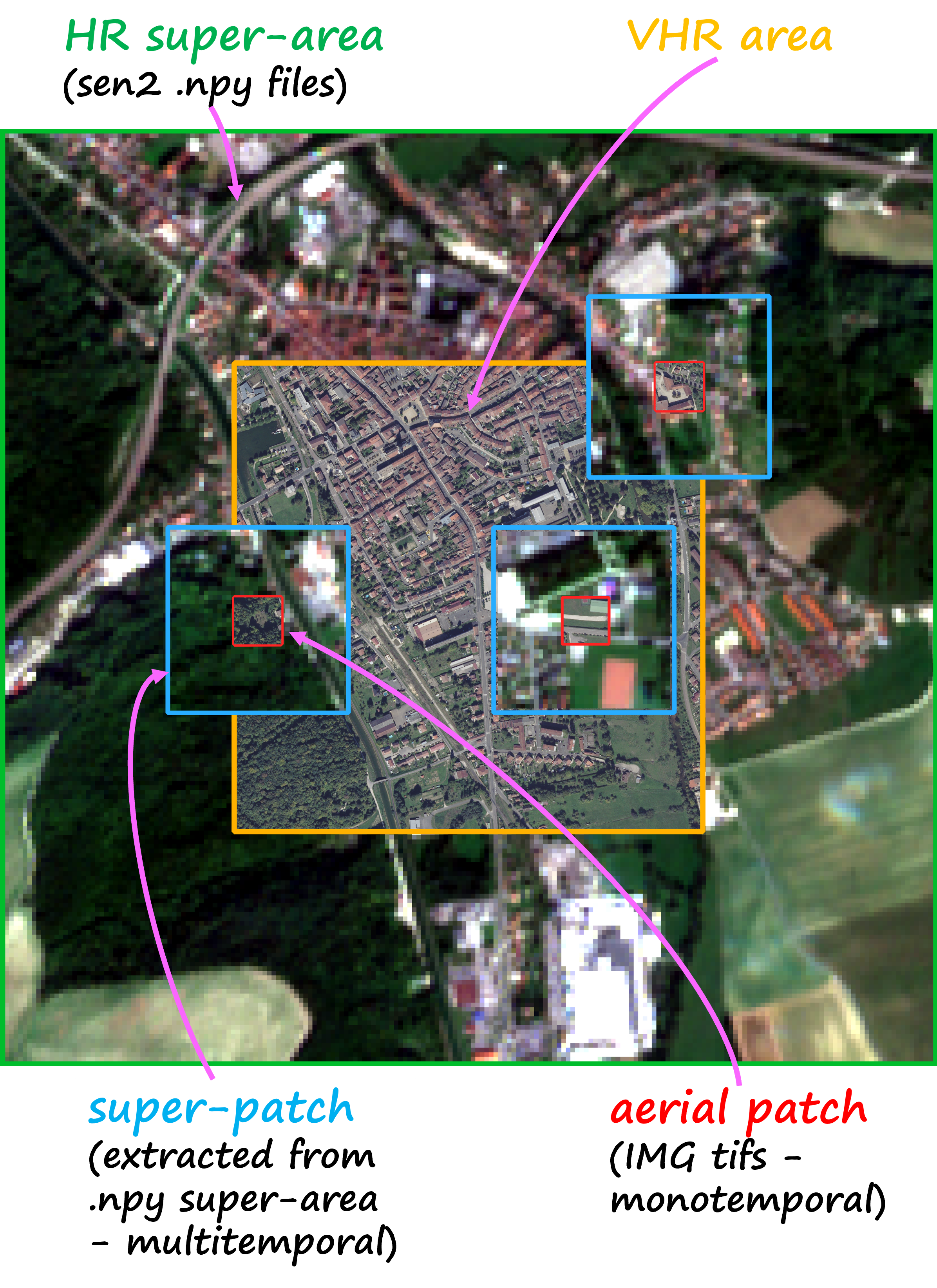

Le jeu de données FLAIR #2 comprend 20,384,841,728 pixels annotés avec une résolution spatiale de 0,20 m à partir d'images aériennes, répartis en 77,762 patchs de taille 512x512. Le jeu de données FLAIR #2 inclut également une vaste collection de données satellites, avec un total de 51,244 acquisitions d'images des satellites Copernicus Sentinel-2. Pour chaque zone, les acquisitions sur un an ont été retenues, offrant des informations précieuses sur la dynamique spatio-temporelle et les caractéristiques spectrales de la couverture terrestre. En raison de la différence significative de résolution spatiale entre les images aériennes et les données satellites, les zones initialement définies manquent de contexte suffisant car elles ne sont composées que de quelques pixels Sentinel-2. Pour remédier à cela, une marge a été appliquée pour créer des zones plus grandes appelées super-zones. Cela garantit que chaque patch du jeu de données est associé à une super-zone de données Sentinel-2 de taille suffisante, offrant un niveau minimum de contexte provenant du satellite.

Le jeu de données couvre 50 domaines spatial, comprenant 916 zones réparties sur 817 km². Avec 13 classes sémantiques (plus 6 non utilisées dans ce défi), ce jeu de données constitue une base solide pour faire progresser les techniques de cartographie de la couverture du sol.

| Class | Value | Freq.-train (%) | Freq.-test (%) | |

|---|---|---|---|---|

| building | 1 | 8.14 | 3.26 | |

| pervious surface | 2 | 8.25 | 3.82 | |

| impervious surface | 3 | 13.72 | 5.87 | |

| bare soil | 4 | 3.47 | 1.6 | |

| water | 5 | 4.88 | 3.17 | |

| coniferous | 6 | 2.74 | 10.24 | |

| deciduous | 7 | 15.38 | 24.79 | |

| brushwood | 8 | 6.95 | 3.81 | |

| vineyard | 9 | 3.13 | 2.55 | |

| herbaceous vegetation | 10 | 17.84 | 19.76 | |

| agricultural land | 11 | 10.98 | 18.19 | |

| plowed land | 12 | 3.88 | 1.81 | |

| swimming pool | 13 | 0.01 | 0.02 | |

| snow | 14 | 0.15 | - | |

| clear cut | 15 | 0.15 | 0.82 | |

| mixed | 16 | 0.05 | 0.12 | |

| ligneous | 17 | 0.01 | - | |

| greenhouse | 18 | 0.12 | 0.15 | |

| other | 19 | 0.14 | 0.04 |

▶️ Modèle de référence (baseline): U-T&T (cliquer pour agrandir)

Nous proposons le modèle U-T&T, une architecture à deux branches qui combine les informations spatiales et temporelles à partir d'images aériennes très haute résolution et d'images satellites haute résolution en une seule sortie. L'architecture U-Net est utilisée pour la branche spatiale/texture, en utilisant un modèle avec un encodeur ResNet34 pré-entraîné sur ImageNet. Pour la branche spatio-temporelle, l'architecture U-TAE intègre un Encodeur à Attention Temporelle (TAE) pour explorer les caractéristiques spatiales et temporelles des séries temporelles de Sentinel-2, en appliquant des masques d'attention à différentes résolutions lors du décodage. Ce modèle permet la fusion des informations apprises à partir des deux sources.

▶️ Téléchargement du dataset (cliquer pour agrandir)

Pour l'instant sur inscription au défi !

| Données | Volume | Type | Lien |

|---|---|---|---|

| Images aériennes - entraînement | 50.7 Go | .zip | - |

| Images aériennes - test | 13.4 Go | .zip | - |

| Images Sentinel-2 - entraînement | 22.8 Go | .zip | - |

| Images Sentinel-2 - test | 6 Go | .zip | - |

| Annotations - entraînement | 485 Mo | .zip | - |

| Annotations - test | 108 Mo | .zip | - |

| Métadonnées aériennes | 16.1 Mo | .json | - |

| Correspondance images aériennes <-> Sentinel-2 | 16.1 Mo | .json | - |

| Shapefile zones | 392 Ko | .gpkg | - |

| Jeu de données exemple (entraînement et test réduits) | 1.6 Go/td> | .zip | download |

Citation

Si vous utilisez des données de FLAIR #2, merci d'inclure la citation suivante:

Texte brut:

Anatol Garioud, Nicolas Gonthier, Loic Landrieu, Apolline De Wit, Marion Valette, Marc Poupée, Sébastien Giordano and Boris Wattrelos. 2023.

FLAIR: a Country-Scale Land Cover Semantic Segmentation Dataset From Multi-Source Optical Imagery. (2023).

DOI: https://doi.org/10.48550/arXiv.2310.13336

BibTex:

@inproceedings{ign2023flair2,

title={FLAIR: a Country-Scale Land Cover Semantic Segmentation Dataset From Multi-Source Optical Imagery},

author={Anatol Garioud and Nicolas Gonthier and Loic Landrieu and Apolline De Wit and Marion Valette and Marc Poupée and Sébastien Giordano and Boris Wattrelos},

year={2023},

booktitle={Advances in Neural Information Processing Systems (NeurIPS) 2023},

doi={https://doi.org/10.48550/arXiv.2310.13336},

}